Semantic Chunking – Cắt dữ liệu dựa trên ý nghĩa nội dung hiệu quả

Trong quá trình xử lý dữ liệu văn bản cho AI và các ứng dụng NLP, việc chia nhỏ dữ liệu (chunking) là bước quan trọng để đảm bảo mô hình hiểu đúng ngữ cảnh. Semantic Chunking – cắt dữ liệu dựa trên ý nghĩa nội dung giúp tách văn bản theo câu hoặc đoạn trọn vẹn, tránh tình trạng cắt giữa chừng làm mất mạch ý.

Semantic Chunking là gì?

Semantic Chunking (cắt dữ liệu dựa trên ý nghĩa nội dung) là phương pháp chia văn bản thành các khối (chunk) sao cho mỗi khối vẫn giữ được ngữ cảnh trọn vẹn, thường là theo câu hoặc đoạn văn. Khác với cách cắt theo số token hoặc ký tự – vốn có thể khiến văn bản bị đứt đoạn giữa chừng – Semantic Chunking ưu tiên giữ nguyên thông điệp, đảm bảo AI có thể đọc hiểu và xử lý thông tin đầy đủ.

Ví dụ:

- Nếu cắt đoạn “Khách hàng là trung tâm của mọi chiến lược. Doanh nghiệp cần liên tục cải tiến dịch vụ.” thành hai chunk theo ngữ nghĩa → mỗi chunk tương ứng một câu, rõ ràng và đủ ý.

- Nếu cắt theo token (ví dụ 15 token) → có thể ra “Khách hàng là trung tâm của mọi chiến lược. Doanh nghiệp cần li…”, khiến AI khó hiểu đúng ý.

Vì sao cần Semantic Chunking?

- Giữ ngữ cảnh đầy đủ: Một câu hay đoạn văn thường chứa đầy đủ thông tin để AI hiểu. Nếu cắt sai, mô hình có thể bỏ sót từ khóa quan trọng hoặc mất kết nối với ngữ cảnh.

- Tăng độ chính xác khi tìm kiếm: Khi dùng Semantic Search hoặc RAG (Retrieval-Augmented Generation), mỗi chunk là một đơn vị ý nghĩa hoàn chỉnh. Điều này giúp hệ thống dễ dàng truy xuất chính xác phần dữ liệu liên quan.

- Cải thiện trải nghiệm Chatbot AI: Chatbot huấn luyện trên dữ liệu Semantic Chunking sẽ đưa ra phản hồi tự nhiên, tránh tình trạng trả lời nửa vời hoặc sai lệch vì thiếu ngữ cảnh.

- Tối ưu dung lượng lưu trữ và truy vấn: Các chunk trọn vẹn về ngữ nghĩa thường ngắn gọn, không dư thừa. Điều này giúp tiết kiệm chi phí embedding và tăng tốc độ truy vấn trong vector database.

Quy trình cắt dữ liệu dựa trên ngữ nghĩa

Việc tuân thủ đúng quy trình trên giúp đảm bảo mỗi chunk vừa có độ dài phù hợp, vừa giữ được ngữ cảnh đầy đủ. Đây chính là nền tảng quan trọng để các bước ứng dụng tiếp theo như RAG, Semantic Search hay Chatbot AI hoạt động hiệu quả và chính xác hơn.

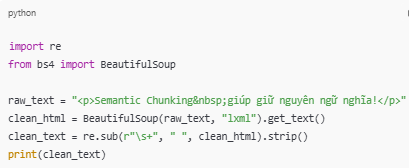

Bước 1 – Tiền xử lý văn bản

Mục tiêu: loại bỏ các ký tự không cần thiết, làm sạch dữ liệu đầu vào.

Cách thực hiện:

- Dùng regex để loại bỏ ký tự đặc biệt (\n, \t, ký tự rác).

- Chuẩn hóa Unicode (NFC hoặc NFKC) để tránh lỗi hiển thị (đặc biệt quan trọng với tiếng Việt).

- Loại bỏ HTML tags bằng thư viện như BeautifulSoup.

import re

from bs4 import BeautifulSoupraw_text = "

Semantic Chunking giúp giữ nguyên ngữ nghĩa!

"

clean_html = BeautifulSoup(raw_text, "lxml").get_text()

clean_text = re.sub(r"\s+", " ", clean_html).strip()

print(clean_text)

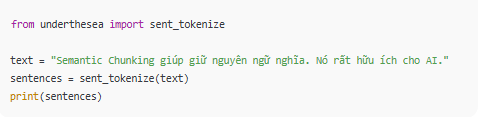

Bước 2 – Xác định đơn vị ngữ nghĩa

Mục tiêu: chia văn bản thành câu hoặc đoạn để giữ ý nghĩa liền mạch.

Cách thực hiện:

- Với tiếng Anh: dùng nltk.sent_tokenize hoặc spacy.

- Với tiếng Việt: dùng underthesea.sent_tokenize() hoặc VnCoreNLP.

- Nếu tài liệu dạng báo cáo/dàn ý → chia theo đoạn (\n\n).

from underthesea import sent_tokenize

text = "Semantic Chunking giúp giữ nguyên ngữ nghĩa. Nó rất hữu ích cho AI."

sentences = sent_tokenize(text)print(sentences)

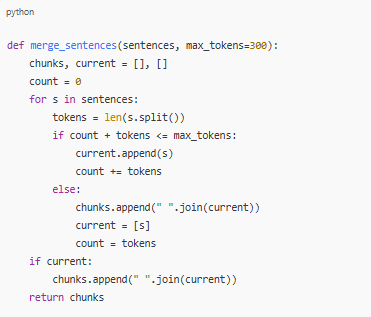

Bước 3 – Xác định độ dài tối ưu cho chunk

Mục tiêu: đảm bảo chunk không quá ngắn, không quá dài.

Quy tắc:

- Mỗi chunk: 200–500 token (tuỳ thuộc context window của LLM).

- Nếu một câu quá dài (trên 500 token) → tách thành nhiều chunk nhỏ hơn.

- Nếu nhiều câu ngắn (

def merge_sentences(sentences, max_tokens=300):

chunks, current = [], []

count = 0

for s in sentences:

tokens = len(s.split())

if count + tokens current.append(s)

count += tokens

else:

chunks.append(" ".join(current))

current = [s]

count = tokens

if current:

chunks.append(" ".join(current))

return chunks

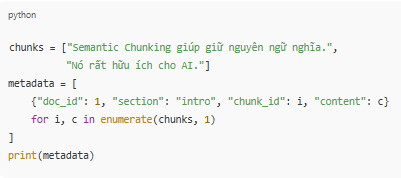

Bước 4 – Gắn metadata

Mục tiêu: giúp dễ dàng quản lý, tìm kiếm, và map dữ liệu về đúng vị trí ban đầu.

Cách thực hiện:

- Gắn doc_id, section, chunk_id.

- Có thể lưu thêm start_char, end_char để biết chunk nằm ở đâu trong văn bản gốc.

chunks = ["Semantic Chunking giúp giữ nguyên ngữ nghĩa.",

"Nó rất hữu ích cho AI."]

metadata = [

{"doc_id": 1, "section": "intro", "chunk_id": i, "content": c}

for i, c in enumerate(chunks, 1)

]

print(metadata)

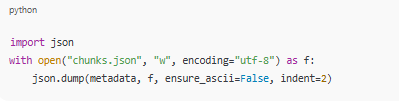

Bước 5 – Xuất dữ liệu

Mục tiêu: lưu dữ liệu đã chunked để phục vụ embedding hoặc search.

Cách thực hiện: Xuất ra CSV (dễ xem thủ công) hoặc JSON (dễ tích hợp API).

import json

with open("chunks.json", "w", encoding="utf-8") as f:

json.dump(metadata, f, ensure_ascii=False, indent=2)

Kết quả: mỗi chunk là một record riêng, có metadata đi kèm → dễ dàng load vào vector DB như Pinecone, Weaviate, Milvus hoặc FAISS.

Tóm lại: Quy trình Semantic Chunking gồm làm sạch dữ liệu → tách câu/đoạn → gom chunk theo token → gắn metadata → export dữ liệu. Nếu dev áp dụng đúng, thì pipeline sẽ cho ra dữ liệu vừa sạch, vừa giữ ngữ nghĩa, sẵn sàng cho embedding & RAG.

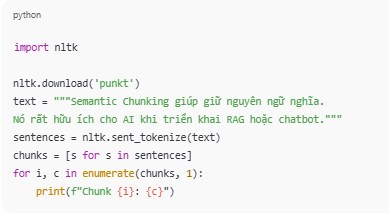

Ví dụ code Python với NLTK:

import nltk

nltk.download('punkt')

text = """Semantic Chunking giúp giữ nguyên ngữ nghĩa.

Nó rất hữu ích cho AI khi triển khai RAG hoặc chatbot."""

sentences = nltk.sent_tokenize(text)

chunks = [s for s in sentences]

for i, c in enumerate(chunks, 1):

print(f"Chunk {i}: {c}")

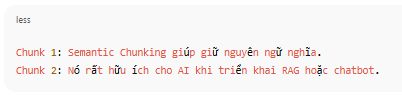

Kết quả

- Chunk 1: Semantic Chunking giúp giữ nguyên ngữ nghĩa.

- Chunk 2: Nó rất hữu ích cho AI khi triển khai RAG hoặc chatbot.

Ứng dụng thực tiễn của Semantic Chunking

- Trong RAG (Retrieval-Augmented Generation): Khi AI cần tham chiếu dữ liệu ngoài, chunk ngữ nghĩa đảm bảo mô hình không bỏ sót chi tiết, đồng thời giảm nhiễu.

- Trong Semantic Search: Người dùng tìm “chiến lược giữ chân khách hàng” → hệ thống sẽ truy xuất đúng chunk chứa nội dung này, thay vì trả về đoạn bị chia nhỏ vô nghĩa.

- Trong Chatbot AI: Chatbot huấn luyện với chunk ngữ nghĩa có thể trả lời tự nhiên, không lặp lại hoặc bị rời rạc.

- Trong tóm tắt văn bản (Summarization): Khi chunk dữ liệu đã mang tính ngữ nghĩa hoàn chỉnh, quá trình tóm tắt sẽ chính xác hơn, giữ nguyên thông điệp cốt lõi.

- Trong hệ thống phân tích dữ liệu: Báo cáo dài có thể được chia nhỏ thành các đoạn logic, giúp hệ thống phân tích dễ dàng phát hiện insight.

Kết bài

Semantic Chunking không chỉ đơn thuần là một kỹ thuật cắt văn bản, mà còn là cách giúp AI và các hệ thống NLP hiểu con người tốt hơn. Thay vì để dữ liệu bị chia nhỏ một cách máy móc, phương pháp này giữ trọn ý nghĩa trong từng chunk, từ đó mang lại độ chính xác và trải nghiệm vượt trội trong các ứng dụng AI hiện đại.

Về trang chủ Bizfly

Về trang chủ Bizfly

Đăng nhập

Đăng nhập

Tài liệu kỹ thuật AI Chat

Tài liệu kỹ thuật AI Chat

Loading ...

Loading ...