Hướng dẫn triển khai bộ nhớ AI Agent chi tiết hiệu quả

Trong thế giới của Large Language Models (LLM) để xây dựng một AI Agent thực sự hữu ích, có khả năng truy cập và xử lý thông tin private, thông tin real-time hoặc kiến thức chuyên ngành, chúng ta cần trang bị cho nó một bộ nhớ ngoài. Bài viết này sẽ đi sâu vào khía cạnh kỹ thuật, hướng dẫn anh em dev từng bước xây dựng một pipeline hoàn chỉnh để triển khai bộ nhớ cho AI Agent.

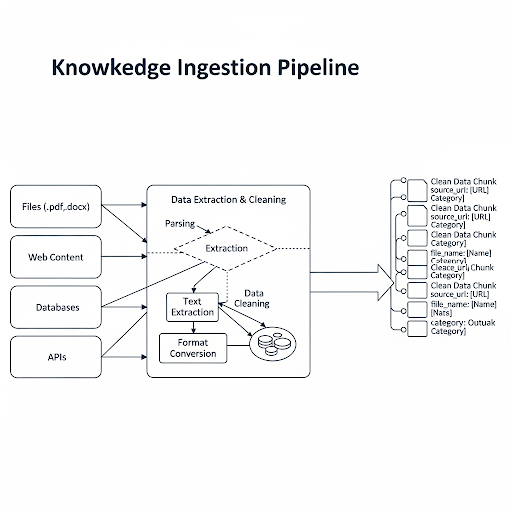

Giai đoạn 1: Luồng thu thập và xử lý dữ liệu (Knowledge Ingestion Pipeline)

Mục tiêu của giai đoạn này là xây dựng một luồng (pipeline) tự động, đáng tin cậy để nạp dữ liệu từ nhiều nguồn khác nhau vào hệ thống. Đây là bước nền tảng, quyết định chất lượng đầu vào của toàn bộ hệ thống bộ nhớ của AI Agent.

1. Data Loading

Đầu tiên, chúng ta cần xác định các nguồn dữ liệu. Dữ liệu có thể ở bất cứ đâu:

- File tài liệu: .pdf, .docx, .txt, .md, .csv...

- Web content: Cào dữ liệu từ một trang web hoặc bộ tài liệu online.

- Database: Dữ liệu có cấu trúc từ SQL hoặc NoSQL database.

- API: Dữ liệu từ các hệ thống bên thứ ba.

Để xử lý việc này, việc sử dụng các thư viện như LangChain với bộ DocumentLoaders là một lựa chọn cực kỳ hiệu quả. Mỗi loại loader được thiết kế để đọc và parse một định dạng dữ liệu cụ thể, trả về một đối tượng Document chuẩn hóa chứa content và metadata.

2. Data Extraction & Cleaning

Dữ liệu thô thường chứa rất nhiều nhiễu: các thẻ HTML, ký tự đặc biệt, định dạng thừa... Giai đoạn này tập trung vào việc trích xuất phần text cốt lõi và làm sạch nó.

- Với web content, ta cần loại bỏ HTML tags, JavaScript, CSS.

- Với file PDF, cần xử lý các vấn đề về layout, bảng biểu, header/footer.

- Chuẩn hóa text: chuyển về chữ thường (lowercase), xử lý encoding, xóa các khoảng trắng thừa.

3. Metadata Extraction (Quan trọng):

Trong quá trình load dữ liệu, đừng chỉ lấy content. Hãy trích xuất và gắn thêm metadata cho mỗi Document. Metadata có thể là:

- Nguồn gốc của tài liệu (source_url, file_name).

- Ngày tạo, ngày cập nhật.

- Tác giả, category...

Metadata cực kỳ hữu ích ở giai đoạn sau, cho phép chúng ta thực hiện các bộ lọc phức tạp khi truy vấn (ví dụ: "chỉ tìm kiếm trong các tài liệu thuộc category 'Kỹ thuật' được cập nhật trong tháng trước"). Một pipeline ingestion tốt cần phải robust, có khả năng logging và xử lý lỗi hiệu quả.

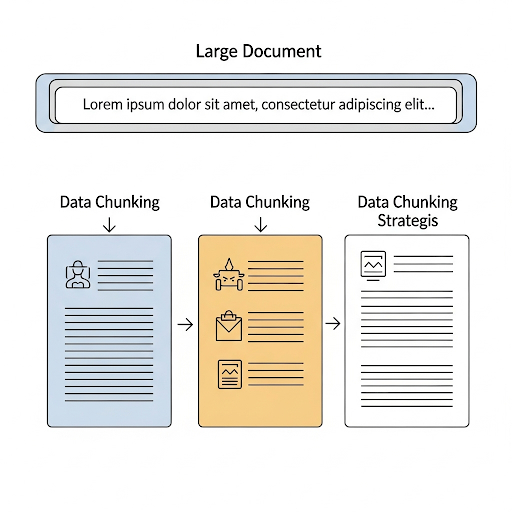

Giai đoạn 2: Chiến lược Chunking dữ liệu

LLM có một giới hạn về số lượng token nó có thể xử lý trong một lần gọi, gọi là "context window". Chúng ta không thể đưa toàn bộ một tài liệu dài hàng trăm trang vào prompt. Do đó, ta phải chia nhỏ (chunking) tài liệu thành các đoạn nhỏ hơn, có ý nghĩa. Việc chọn chiến lược chunking ảnh hưởng trực tiếp đến chất lượng retrieval sau này.

1. Fixed-Size Chunking

Đây là phương pháp đơn giản nhất: chia văn bản thành các chunk có kích thước cố định (ví dụ: 1000 ký tự) và có thể thêm một khoảng overlap (phần gối đầu giữa hai chunk liên tiếp để tránh mất ngữ cảnh).

- Ưu điểm: Dễ triển khai.

- Nhược điểm: Có thể cắt câu, cắt đoạn một cách vô nghĩa, làm mất ngữ cảnh quan trọng. Thường dùng CharacterTextSplitter.

2. Recursive Character Text Splitter (Khuyến khích)

Đây là phương pháp được sử dụng phổ biến và hiệu quả nhất hiện nay. Nó cố gắng chia văn bản dựa trên một danh sách các ký tự phân tách theo thứ tự ưu tiên. Ví dụ, nó sẽ thử chia theo \n\n (xuống dòng 2 lần - hết đoạn), nếu chunk vẫn quá dài, nó sẽ thử chia theo \n (xuống dòng), rồi đến dấu cách , rồi đến ký tự rỗng "".

3. Semantic Chunking (Nâng cao)

Thay vì chia theo số lượng ký tự hoặc ký tự phân tách, phương pháp này chia văn bản dựa trên sự thay đổi về ngữ nghĩa. Nó tính toán khoảng cách (similarity score) giữa các câu liên tiếp bằng cách sử dụng embedding. Nếu khoảng cách giữa hai câu vượt một ngưỡng nhất định, nó sẽ tạo ra một điểm chia.

- Ưu điểm: Tạo ra các chunk có tính gắn kết về mặt ngữ nghĩa cao nhất.

- Nhược điểm: Phức tạp hơn và tốn tài nguyên tính toán hơn.

Lưu ý khi chunking:

- Chunk Size: Kích thước chunk cần đủ nhỏ để vừa với context window nhưng cũng phải đủ lớn để chứa trọn vẹn một ý nghĩa.

- Chunk Overlap: Một khoảng overlap hợp lý (10-20% chunk size) giúp đảm bảo ngữ cảnh không bị mất ở các điểm nối giữa hai chunk.

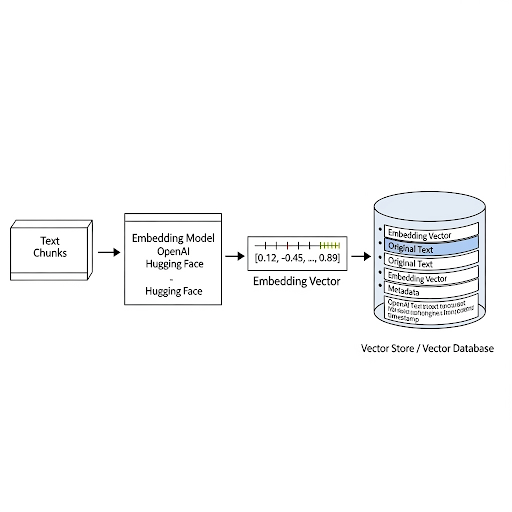

Giai đoạn 3: Tạo embedding và lưu trữ Vector

Sau khi đã có các chunk dữ liệu, chúng ta cần một cách để máy tính hiểu được ngữ nghĩa của chúng. Đây là lúc Embedding và Vector Store vào cuộc.

1. Tạo Embedding

Embedding là quá trình chuyển đổi một đoạn text (chunk) thành một vector số thực (một mảng các con số, ví dụ: [0.12, -0.45, ..., 0.89]). Các mô hình embedding được train để những đoạn text có ngữ nghĩa tương tự nhau sẽ có vector ở gần nhau trong không gian vector.

Lựa chọn Embedding Model:

Proprietary (API): OpenAI text-embedding-3-small, text-embedding-3-large, các model của Cohere. Dễ dùng, hiệu năng cao.

Open-source: Các model từ Hugging Face như sentence-transformers/all-mpnet-base-v2 (tiếng Anh) hoặc bkai-foundation-models/vietnamese-bi-encoder (tiếng Việt). Cho phép self-host, toàn quyền kiểm soát.

2. Lưu trữ Vector (Vector Store/Vector Database)

Sau khi có các vector embedding, chúng ta cần một nơi để lưu trữ và truy vấn chúng một cách hiệu quả. Đây là nhiệm vụ của Vector Store. Chức năng chính của nó là thực hiện tìm kiếm tương đồng (similarity search) cực nhanh trên hàng triệu, thậm chí hàng tỷ vector.

- Input: Một vector truy vấn (query vector).

- Output: k vector gần nhất với vector truy vấn đó (thuật toán cốt lõi là Approximate Nearest Neighbor - ANN).

Các lựa chọn Vector Store phổ biến:

- Local/In-memory: FAISS (của Meta), ChromaDB. Phù hợp cho việc phát triển, thử nghiệm, hoặc các ứng dụng nhỏ.

- Cloud/Managed Service: Pinecone, Weaviate, Milvus. Cung cấp khả năng scale, độ bền và các tính năng quản trị cho môi trường production.

Quy trình thực hiện: Lặp qua từng chunk dữ liệu -> Dùng embedding model để tạo vector -> Lưu trữ cặp (vector, original_text, metadata) vào Vector Store.

Giai đoạn 4: Quản lý bộ nhớ của AI Agent

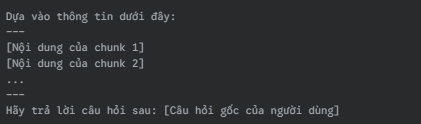

Đây là giai đoạn kết nối tất cả các thành phần lại với nhau để AI Agent có thể thực sự sử dụng bộ nhớ của AI Agent. Luồng hoạt động này thường được gọi là Retrieval-Augmented Generation (RAG).

Luồng RAG cơ bản:

- User Query: Người dùng đặt một câu hỏi.

- Query Embedding: Câu hỏi của người dùng được chuyển thành một vector bằng chính embedding model đã dùng ở Giai đoạn 3.

- Similarity Search: Vector của câu hỏi được gửi đến Vector Store để tìm kiếm k chunk văn bản có vector gần nhất (liên quan nhất về mặt ngữ nghĩa).

- Context Augmentation: k chunk văn bản được truy xuất này (gọi là "context") được lấy ra.

- Prompt Generation: Một prompt đặc biệt được tạo ra, kết hợp cả câu hỏi gốc của người dùng và phần context đã truy xuất. Ví dụ:

6. LLM Invocation: Prompt hoàn chỉnh này được gửi đến LLM.

7. Final Answer: LLM sẽ tạo ra câu trả lời dựa trên kiến thức của nó và thông tin được cung cấp trong context giúp câu trả lời chính xác và bám sát vào dữ liệu trong bộ nhớ.

Các loại bộ nhớ:

- Long-term memory: Chính là Vector Store mà chúng ta vừa xây dựng. Nó chứa toàn bộ kiến thức nền.

- Short-term memory: Thường là lịch sử của cuộc hội thoại hiện tại (ConversationBufferMemory). Việc kết hợp cả hai loại bộ nhớ này cho phép agent vừa nhớ những gì vừa nói, vừa có khả năng truy xuất kiến thức sâu rộng.

Kết luận

Triển khai bộ nhớ cho AI Agent không phải là một công việc tầm thường, nó là một quy trình kỹ thuật gồm nhiều bước liên kết chặt chẽ. Từ việc xây dựng một Knowledge Ingestion Pipeline vững chắc, lựa chọn chiến lược Chunking thông minh, tạo Embedding chất lượng, cho đến việc sử dụng Vector Store hiệu quả để thực hiện Retrieval, mỗi giai đoạn đều đóng vai trò then chốt quyết định hiệu suất của toàn hệ thống.

Hiểu rõ bản chất của từng bước và các lựa chọn công nghệ đi kèm sẽ giúp anh em developer xây dựng được các AI Agent mạnh mẽ, có khả năng học hỏi và tương tác dựa trên những nguồn kiến thức chuyên biệt, mở ra vô vàn ứng dụng thực tiễn. Chúc anh em code vui!

Về trang chủ Bizfly

Về trang chủ Bizfly

Đăng nhập

Đăng nhập

Tài liệu kỹ thuật AI Chat

Tài liệu kỹ thuật AI Chat

Loading ...

Loading ...