Hướng dẫn đồng bộ dữ liệu từ nhiều nguồn về một hệ thống AI

Trong kỷ nguyên dữ liệu bùng nổ, việc đồng bộ dữ liệu từ nhiều nguồn về một hệ thống AI trở thành nền tảng quan trọng để xây dựng các mô hình thông minh. Một kiến trúc pipeline dữ liệu (ETL) đơn giản không chỉ giúp làm sạch và tổ chức dữ liệu, mà còn mở đường cho các ứng dụng Retrieval Augmented Generation (RAG) hoạt động chính xác và hiệu quả hơn.

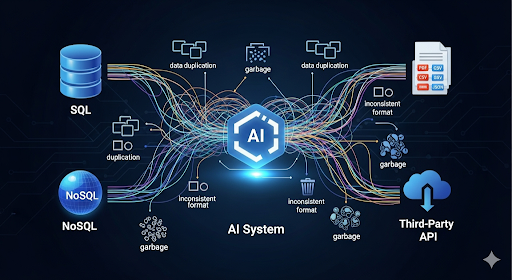

Bối cảnh và thách thức khi đồng bộ dữ liệu

Khi xây dựng một hệ thống AI, dữ liệu không chỉ đến từ một nguồn duy nhất. Developer thường phải xử lý dữ liệu rải rác ở:

- CSDL quan hệ (MySQL, PostgreSQL, SQL Server).

- CSDL phi quan hệ (MongoDB, Elasticsearch).

- File tài liệu (PDF, DOCX, HTML, CSV).

- API của bên thứ ba (CRM, ERP, hệ thống thương mại điện tử).

Nếu không có pipeline xử lý, developer sẽ gặp các vấn đề: dữ liệu bị trùng lặp, định dạng không đồng nhất, text lẫn nhiều ký tự rác, hoặc thiếu metadata để AI hiểu ngữ cảnh.

Thiết kế pipeline ETL cơ bản cho RAG

Để xây dựng một hệ thống Retrieval Augmented Generation (RAG) hoạt động hiệu quả, developer cần một pipeline dữ liệu chặt chẽ nhằm đảm bảo dữ liệu đi qua các bước trích xuất – chuyển đổi – nạp vào hệ thống một cách tối ưu. Đây là quá trình quan trọng giúp AI có ngữ cảnh đầy đủ và hạn chế tình trạng “hallucination”.

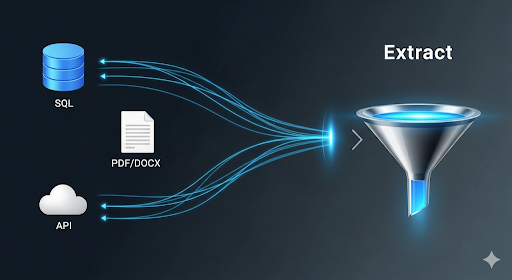

Extract – Trích xuất dữ liệu

Ở giai đoạn này, nhiệm vụ chính là kết nối và lấy dữ liệu từ các nguồn khác nhau, càng tự động hóa càng tốt để giảm thao tác thủ công.

Từ cơ sở dữ liệu:

Developer có thể dùng SQLAlchemy trong Python để kết nối đa dạng CSDL quan hệ như MySQL, PostgreSQL, SQL Server. Nếu dùng Node.js, có thể chọn Prisma hoặc Sequelize để truy vấn thuận tiện hơn.

Từ file tài liệu:

- PDF: dùng pdfplumber để tách text từ file có nhiều trang.

- DOCX: sử dụng python-docx để lấy nội dung văn bản có cấu trúc.

- HTML: tận dụng BeautifulSoup (Python) hoặc Cheerio (Node.js) để parse DOM, loại bỏ tag thừa và trích xuất nội dung chính.

Từ API:

Kết nối REST hoặc GraphQL thông qua requests/httpx (Python) hoặc axios (Node.js). Quản lý token/bí mật bằng .env file và dùng thư viện dotenv để tránh hard-code key vào source.

Transform – Làm sạch và chuẩn hóa

Đây là giai đoạn quyết định chất lượng dữ liệu trước khi vào hệ thống AI.

- Chuẩn hóa encoding: convert toàn bộ về UTF-8 để tránh lỗi ký tự khi xử lý đa ngôn ngữ.

- Loại bỏ nhiễu: sử dụng regex hoặc NLP pipeline để loại bỏ ký tự thừa, HTML tag, dấu xuống dòng không cần thiết.

- Chuẩn hóa thời gian: convert toàn bộ về chuẩn ISO 8601 (YYYY-MM-DDTHH:MM:SSZ) để dễ dàng query theo thời gian.

- Tách nhỏ (chunking): chia văn bản thành đoạn 500–1000 token. Kích thước hợp lý giúp RAG truy xuất hiệu quả, tránh out-of-context.

- Embedding: sử dụng sentence-transformers (Python) hoặc gọi API embedding của OpenAI/Anthropic để tạo vector cho từng chunk dữ liệu.

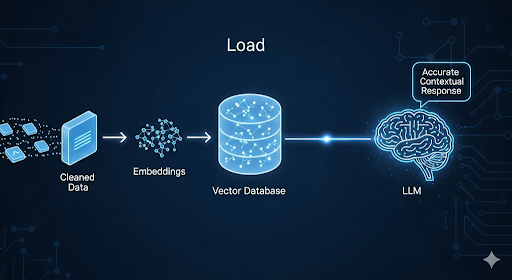

Load – Nạp vào hệ thống AI

Khi dữ liệu đã sạch và có embedding, bước tiếp theo là đưa vào hạ tầng lưu trữ để AI có thể truy vấn.

- Vector Database: lựa chọn Pinecone (SaaS), Weaviate/Milvus (open-source), hoặc FAISS (nhẹ, chạy local).

- Schema lưu trữ: một bản ghi thường gồm 4 trường chính:

- id: định danh duy nhất

- text_chunk: đoạn văn bản

- embedding: vector đã tính toán

- metadata: thông tin bổ sung để filter khi truy vấn

- Kết nối với LLM: sử dụng retrieval layer như LangChain hoặc LlamaIndex để gọi vector search trước khi gửi prompt tới LLM.

Ưu điểm khi áp dụng pipeline ETL cho RAG

Việc áp dụng pipeline ETL vào RAG không chỉ mang ý nghĩa kỹ thuật, mà còn trực tiếp tác động đến độ tin cậy và hiệu suất của hệ thống AI. Dưới đây là những lợi ích nổi bật mà developer và doanh nghiệp có thể nhận được.

Tối ưu hiệu quả truy vấn

Khi dữ liệu đã được chuẩn hóa và index thành vector, quá trình tìm kiếm sẽ diễn ra nhanh chóng và chính xác hơn. Ví dụ, nếu người dùng hỏi “Top 10 khách hàng chi tiêu nhiều nhất quý 2/2025”, hệ thống không cần quét toàn bộ cơ sở dữ liệu thô, mà chỉ cần tìm embedding gần nhất trong vector database.

Giảm thiểu sai sót

Một trong những rủi ro lớn khi làm AI là hallucination – AI trả lời sai hoặc tự bịa thông tin. Pipeline ETL giúp:

- Loại bỏ dữ liệu trùng lặp, tránh việc AI trả về nhiều câu trả lời giống nhau nhưng mâu thuẫn.

- Làm sạch ký tự lỗi, tag HTML, dữ liệu rác để mô hình không bị “nhiễu” khi học.

- Gắn metadata (ngày, nguồn, người tạo) để AI có thể trích dẫn bằng chứng, giảm nguy cơ trả lời không chính xác.

Dễ dàng mở rộng và bảo trì

Một pipeline được thiết kế modular (tách riêng Extract – Transform – Load) cho phép developer:

- Thêm nguồn dữ liệu mới (CRM, ERP, API bên ngoài) chỉ bằng cách viết thêm “data connector” thay vì chỉnh sửa toàn bộ pipeline.

- Thay đổi mô hình embedding (ví dụ từ OpenAI sang sentence-transformers) mà không ảnh hưởng tới luồng dữ liệu.

- Tích hợp thêm vector database khác khi hệ thống lớn mạnh hơn (từ FAISS nội bộ lên Pinecone/Weaviate).

Điều này giúp hệ thống có khả năng phát triển lâu dài mà không bị phụ thuộc vào một công nghệ cố định.

Tăng giá trị kinh doanh

Khi dữ liệu được chuẩn hóa và AI có thể truy xuất chính xác, doanh nghiệp nhận về những lợi ích rõ rệt:

- Khách hàng được hỗ trợ nhanh chóng: Chatbot AI có thể trả lời ngay từ kho dữ liệu, không cần chờ nhân viên.

- Marketing chính xác hơn: RAG kết hợp dữ liệu từ nhiều nguồn (CRM, email, website) để cá nhân hóa thông điệp.

- Quyết định kinh doanh nhanh hơn: Lãnh đạo có thể đặt câu hỏi tự nhiên (“Doanh số theo từng kênh quảng cáo trong tháng 8?”) và AI trả về ngay báo cáo chi tiết.

Kết bài

Việc đồng bộ dữ liệu từ nhiều nguồn về một hệ thống AI thông qua pipeline ETL đơn giản chính là nền móng vững chắc cho các mô hình RAG. Khi dữ liệu được chuẩn hóa và tích hợp hiệu quả, doanh nghiệp không chỉ tối ưu hiệu suất AI mà còn mở rộng khả năng ứng dụng trong bán hàng, marketing và chăm sóc khách hàng.

Về trang chủ Bizfly

Về trang chủ Bizfly

Đăng nhập

Đăng nhập

Tài liệu kỹ thuật AI Chat

Tài liệu kỹ thuật AI Chat

Loading ...

Loading ...