Áp dụng context caching để tăng tốc phản hồi với Redis

Khi xây dựng chatbot hoặc ứng dụng AI, chắc hẳn bạn từng gặp tình huống người dùng hỏi đi hỏi lại một câu giống nhau. Nếu hệ thống phải chạy toàn bộ pipeline từ tìm kiếm dữ liệu cho đến sinh câu trả lời mỗi lần, tốc độ phản hồi sẽ chậm và tốn tài nguyên. Một cách làm thông minh là tận dụng context caching với Redis, để lưu lại kết quả cho những câu hỏi lặp lại và tái sử dụng trong những lần tiếp theo.

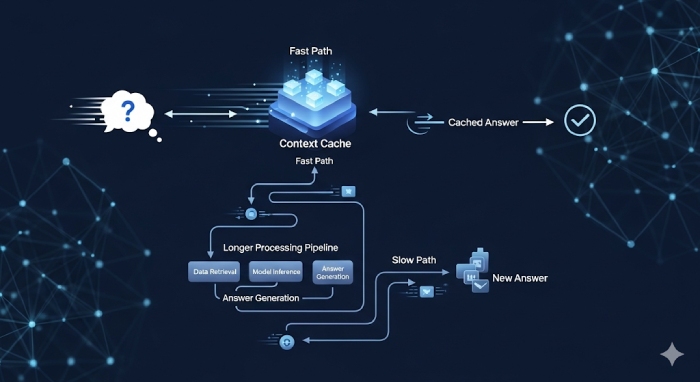

Hiểu về context caching trong hệ thống AI

Context caching có thể hình dung đơn giản như một bộ nhớ tạm. Khi người dùng gửi câu hỏi, hệ thống sẽ kiểm tra xem câu hỏi đó đã từng được xử lý chưa. Nếu có rồi, câu trả lời sẽ được lấy trực tiếp từ cache mà không cần gọi lại toàn bộ pipeline. Với những use case như FAQ hay trợ lý ảo chăm sóc khách hàng, đây là cách giúp tiết kiệm tài nguyên và rút ngắn thời gian phản hồi đáng kể.

Vì sao Redis là lựa chọn phù hợp

Redis là một công cụ lưu trữ key-value trong bộ nhớ, nổi tiếng với tốc độ cực nhanh. Đối với dev, Redis mang lại một số lợi thế rõ rệt:

- Độ trễ thấp, chỉ tính bằng mili-giây.

- Có thể đặt thời gian sống (TTL) cho mỗi key, tránh tình trạng dữ liệu quá cũ.

- Hỗ trợ nhiều cấu trúc dữ liệu khác nhau giúp dev linh hoạt trong việc lưu trữ.

- Dễ tích hợp với Node.js, Python hoặc bất kỳ backend nào.

Trong thực tế, Redis thường được dùng để cache session, token, dữ liệu tạm. Khi áp dụng cho context caching, Redis trở thành một tầng đệm giúp chatbot phản hồi nhanh hơn mà không cần xử lý lặp lại.

Demo áp dụng Redis trong cache câu hỏi thường gặp

Giả sử bạn có một chatbot hỗ trợ thương mại điện tử, và khách hàng hay hỏi: Thời gian giao hàng bao lâu, chính sách đổi trả thế nào. Những câu hỏi này gần như cố định, nên rất phù hợp để cache. Cách triển khai cơ bản như sau:

Bước 1: Chuẩn hóa câu hỏi thành key

Trước khi đưa vào Redis, cần normalize câu hỏi: hạ hết về chữ thường, loại bỏ ký tự đặc biệt.

Ví dụ: câu hỏi "Chính sách đổi trả" có thể thành key faq:chinh_sach_doi_tra.

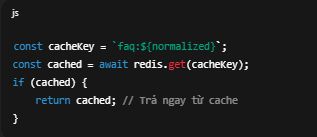

Bước 2: Kiểm tra dữ liệu trong cache

Khi nhận được câu hỏi, hệ thống sẽ check Redis trước. Nếu key đã tồn tại, lập tức trả về kết quả.

const cacheKey = `faq:${normalized}`;

const cached = await redis.get(cacheKey);

if (cached) {

return cached; // Trả ngay từ cache

}

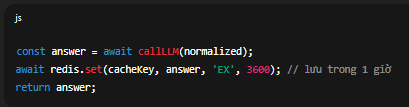

Bước 3: Gọi LLM khi chưa có dữ liệu

Nếu không có trong cache, lúc này mới gọi LLM hoặc pipeline tìm kiếm dữ liệu. Sau đó, lưu kết quả vào Redis kèm TTL để tái sử dụng sau.

const answer = await callLLM(normalized);

await redis.set(cacheKey, answer, 'EX', 3600); // lưu trong 1 giờ

return answer;

Bước 4: Trả về cho người dùng

Lần tiếp theo nếu có người hỏi cùng câu đó, bot sẽ trả lời tức thì mà không tốn thêm chi phí xử lý.

Những lợi ích rõ rệt khi dùng context caching

- Giảm độ trễ phản hồi: Người dùng gần như nhận được câu trả lời ngay tức thì.

- Tiết kiệm tài nguyên: Hệ thống không phải gọi đi gọi lại LLM, từ đó giảm chi phí.

- Câu trả lời đồng nhất: Đối với FAQ, mọi người đều nhận cùng một kết quả chính xác.

- Dễ scale: Khi lượng truy cập tăng cao, hệ thống vẫn ổn định nhờ Redis gánh bớt tải.

Trong thực tế, dịch vụ Chatbot AI - BizChatAI cũng áp dụng cơ chế context caching với Redis để tăng tốc phản hồi. Nhờ vậy, hệ thống không chỉ đảm bảo tốc độ trả lời gần như tức thì cho các câu hỏi lặp lại, mà còn giúp doanh nghiệp tiết kiệm chi phí vận hành khi triển khai chatbot đa kênh. Đây là lý do tại sao BizChatAI có thể xử lý tốt các tình huống FAQ, tư vấn đơn hàng hay hỗ trợ chăm sóc khách hàng ở quy mô lớn.

Một số lưu ý cho dev khi triển khai

- Luôn normalize câu hỏi để tránh trường hợp cùng một ý nhưng nhiều cách viết khác nhau.

- Đặt TTL hợp lý để cache không bị stale.

- Kết hợp log hoặc metrics để theo dõi hit/miss của cache, từ đó điều chỉnh chiến lược.

- Với những câu trả lời phụ thuộc vào dữ liệu thời gian thực (như giá sản phẩm, tồn kho), không nên cache quá lâu.

Kết luận

Áp dụng context caching để tăng tốc phản hồi không phải là ý tưởng xa lạ, nhưng khi kết hợp với Redis, bạn sẽ thấy rõ hiệu quả trong các dự án chatbot hay trợ lý ảo. Vừa tối ưu trải nghiệm người dùng, vừa giảm tải cho server, đây là một kỹ thuật dev nên đưa vào ngay từ giai đoạn thiết kế hệ thống.

Về trang chủ Bizfly

Về trang chủ Bizfly

Đăng nhập

Đăng nhập

Tài liệu kỹ thuật AI Chat

Tài liệu kỹ thuật AI Chat

Loading ...

Loading ...