Context Window là gì? Hiểu về cửa sổ ngữ cảnh trong AI & LLM

Nếu từng dùng ChatGPT, Claude hay Gemini, bạn có thể nhận thấy đôi khi mô hình quên phần đầu cuộc trò chuyện hoặc mất ngữ cảnh khi hội thoại kéo dài. Nguyên nhân chính nằm ở Context Window (cửa sổ ngữ cảnh) quyết định mô hình AI có thể nhớ và phản hồi chính xác đến đâu. Bài viết này Bizfly sẽ giúp bạn hiểu trọn vẹn cách hoạt động của nó trong thế hệ AI & LLM.

Tổng quan về Context Window

Định nghĩa Context Window (cửa sổ ngữ cảnh)

Context Window là số lượng token (đơn vị ngôn ngữ nhỏ nhất) mà một mô hình ngôn ngữ lớn (LLM) có thể đọc hiểu và xử lý tại một thời điểm. Hiểu đơn giản, nó là phạm vi trí nhớ tạm thời mà AI dùng để phân tích câu hỏi, văn bản hoặc lịch sử hội thoại trước đó.

Ví dụ, nếu một mô hình có context window là 8.000 token, nghĩa là nó chỉ có thể xem xét khoảng 6.000 – 7.000 từ gần nhất trong cuộc trò chuyện để tạo phản hồi. Phần nội dung vượt quá giới hạn này sẽ bị rơi khỏi bộ nhớ khiến AI không còn tham chiếu được.

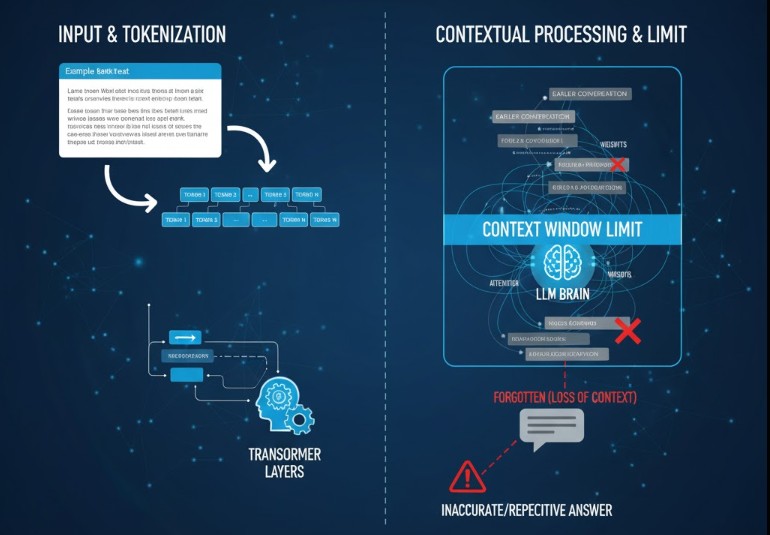

Cơ chế hoạt động của Context Window

Mỗi lần bạn nhập dữ liệu (prompt), LLM sẽ biến đổi toàn bộ văn bản thành chuỗi token và xử lý chúng qua các lớp Transformer. Tại đây, mỗi token được gán trọng số ngữ cảnh (attention weight) để mô hình hiểu mối liên hệ giữa các phần thông tin.

Cửa sổ ngữ cảnh giới hạn khoảng cách mà mô hình có thể duy trì sự liên kết logic. Khi văn bản quá dài, phần đầu bị cắt khỏi phạm vi xử lý dẫn đến hiện tượng mô hình mất ngữ cảnh, trả lời sai hoặc lặp lại.

Phân biệt Context Window và Memory (Bộ nhớ) trong LLM

Context Window là trí nhớ ngắn hạn của mô hình, chỉ tồn tại trong một phiên làm việc. Nó chứa toàn bộ nội dung hội thoại hoặc văn bản được xử lý hiện tại và khi vượt giới hạn token, phần thông tin cũ sẽ bị loại bỏ.

Ngược lại, Memory là bộ nhớ dài hạn, cho phép AI lưu lại dữ liệu từ nhiều phiên khác nhau như thông tin người dùng, phong cách trò chuyện hay kiến thức đã học.

Trong các LLM hiện nay, hai yếu tố này thường được kết hợp song song: Context Window giữ mạch ngữ cảnh tức thời, còn Memory giúp mô hình duy trì hiểu biết liên tục và phản hồi ngày càng chính xác, tự nhiên hơn.

Tầm quan trọng của Context Window

Context Window không chỉ quyết định AI hiểu được bao nhiêu thông tin cùng lúc, mà còn ảnh hưởng trực tiếp đến chất lượng, tính liền mạch và khả năng ứng dụng thực tế của mô hình. Cửa sổ ngữ cảnh càng rộng, mô hình càng có tầm nhìn xa giúp phân tích, tổng hợp và phản hồi chính xác hơn trong nhiều tình huống phức tạp.

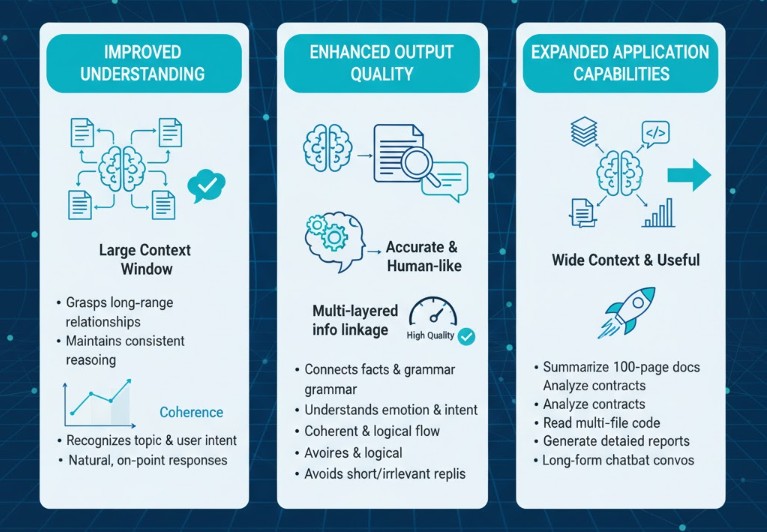

Cải thiện độ hiểu

Context Window lớn giúp mô hình nắm bắt mối quan hệ giữa các phần nội dung xa nhau, duy trì dòng suy luận nhất quán xuyên suốt văn bản. Với ngữ cảnh đủ dài, AI không chỉ hiểu từng câu riêng lẻ mà còn nhận biết chủ đề, mục tiêu và cảm xúc tổng thể của người dùng từ đó tạo ra phản hồi tự nhiên, đúng trọng tâm và ít sai lệch hơn.

Tăng chất lượng đầu ra

Khi có đủ ngữ cảnh, mô hình có thể liên kết thông tin đa tầng từ dữ liệu, cấu trúc ngữ pháp cho đến cảm xúc và ý định giao tiếp. Điều này giúp đầu ra của AI không chỉ chính xác mà còn mạch lạc, logic và mang tính con người hơn tránh được tình trạng trả lời ngắn, rời rạc hoặc thiếu căn cứ.

Mở rộng khả năng ứng dụng

Việc mở rộng context window cho phép AI xử lý nhiều loại dữ liệu phức tạp cùng lúc từ tóm tắt tài liệu hàng trăm trang, phân tích hợp đồng, đọc mã nguồn nhiều file, đến viết báo cáo hoặc hỗ trợ hội thoại dài trong chatbot. Đây chính là bước tiến giúp các mô hình LLM trở nên đa năng và hữu ích hơn trong môi trường doanh nghiệp hiện đại.

Kích thước Context Window của các LLM hàng đầu

Kích thước là một trong những yếu tố quan trọng nhất khi đánh giá năng lực của các mô hình ngôn ngữ lớn (LLM). Nó quyết định mô hình có thể nhìn thấy và xử lý được bao nhiêu dữ liệu cùng lúc từ vài nghìn đến hàng triệu token. Cửa sổ ngữ cảnh càng lớn, khả năng hiểu mạch văn bản, tóm tắt tài liệu hoặc duy trì hội thoại dài càng được cải thiện đáng kể.

Bảng so sánh các mô hình AI nổi bật:

| Mô hình | Context Window (Token) | Năm ra mắt | Ghi chú |

| GPT-4 Turbo (OpenAI) | 128K | 2024 | Dùng cho hội thoại dài, phân tích tài liệu hàng trăm trang. |

| Claude 3.5 (Anthropic) | 200K | 2024 | Đọc và hiểu tới 500 trang văn bản liên tục, nổi bật về khả năng duy trì mạch nội dung. |

| Gemini 1.5 Pro (Google) | 1 triệu | 2025 | Context dài nhất hiện nay, hỗ trợ dữ liệu đa phương tiện như video, âm thanh và code. |

| Mistral Large | 32K | 2024 | Nhẹ, tốc độ cao, phù hợp triển khai thực tế với chi phí thấp. |

Bảng trên cho thấy xu hướng chung của các mô hình hàng đầu là không ngừng mở rộng giới hạn context từ vài nghìn token ở thế hệ GPT-3 lên hàng trăm nghìn, thậm chí hàng triệu token ở thế hệ mới, đưa AI tiến gần hơn đến khả năng ghi nhớ toàn diện.

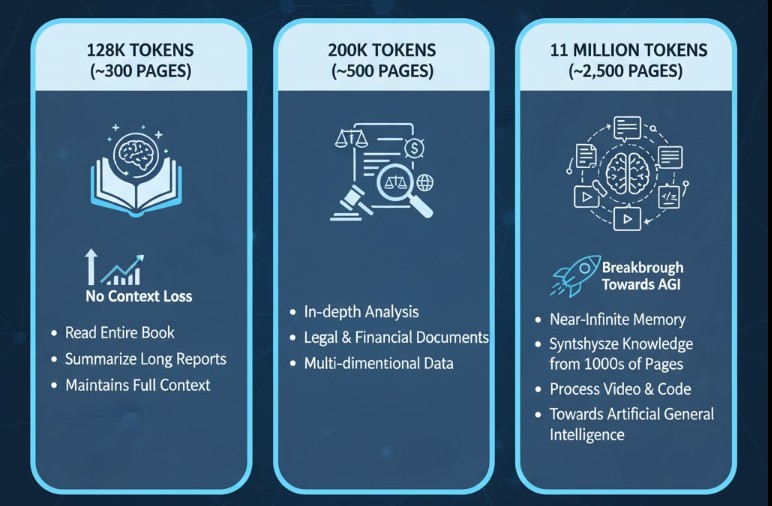

Mỗi lần nâng cấp context window không chỉ tăng dung lượng xử lý mà còn mở ra một cấp độ hiểu biết mới của mô hình:

- 128K token (~300 trang): đủ để AI đọc trọn vẹn một quyển sách hoặc tóm tắt báo cáo dài mà không mất ngữ cảnh.

- 200K token (~500 trang): thích hợp cho các bài toán chuyên sâu như phân tích hợp đồng, dữ liệu pháp lý hay tài chính đa chiều.

- 1 triệu token (~2.500 trang): gần như bộ nhớ tạm thời vô hạn, cho phép AI tổng hợp kiến thức từ hàng ngàn trang văn bản, video và mã nguồn cùng lúc một bước đột phá hướng tới trí tuệ nhân tạo toàn diện (AGI).

Nhờ vậy, mô hình không còn bị giới hạn bởi kích thước dữ liệu đầu vào, mà có thể xử lý ngữ cảnh phức tạp trong phạm vi gần với con người.

Hơn nữa, các hãng công nghệ lớn đang theo đuổi mục tiêu “Infinite Context”, nơi AI không cần quên bất cứ thông tin nào trong quá trình tương tác. Để đạt được điều này, họ ứng dụng các kỹ thuật tiên tiến như:

- Token Compression: nén và biểu diễn thông tin dài dưới dạng vector gọn hơn mà vẫn giữ được ngữ nghĩa.

- Attention Sliding: cho phép mô hình “trượt” qua văn bản dài mà không phải tải toàn bộ vào cùng lúc, giảm chi phí tính toán.

- Hierarchical Retrieval: tổ chức ngữ cảnh theo nhiều tầng (chủ đề, đoạn, câu) để truy xuất thông tin nhanh và chính xác hơn.

Xu hướng này không chỉ giúp AI hiểu sâu hơn, phản hồi thông minh hơn, mà còn mở rộng ứng dụng trong doanh nghiệp từ tổng hợp tri thức nội bộ đến tạo agent chuyên biệt cho từng lĩnh vực.

Thách thức và hạn chế của Context Window dài

Dù mở rộng Context Window mang lại nhiều lợi ích về khả năng hiểu và xử lý ngữ cảnh, nhưng nó cũng kéo theo không ít thách thức về hiệu năng, chi phí và độ chính xác. Việc tìm ra điểm cân bằng giữa độ dài ngữ cảnh và hiệu quả thực tế đang là bài toán lớn cho cả nhà phát triển lẫn doanh nghiệp ứng dụng AI.

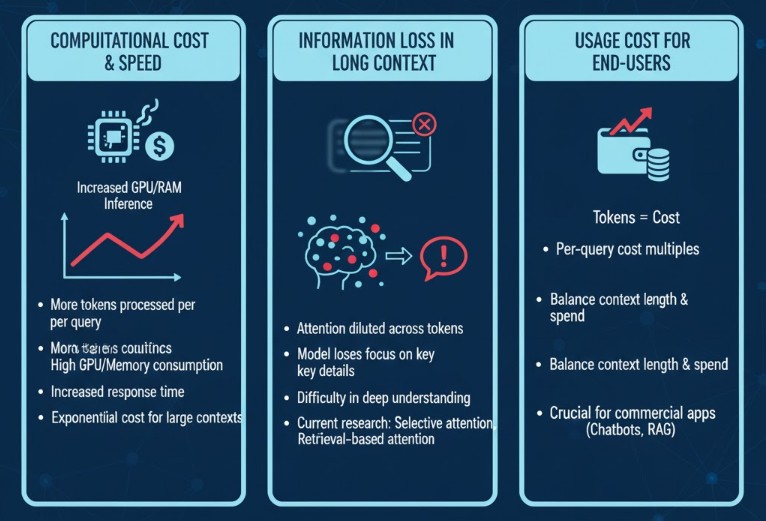

Chi phí tính toán và tốc độ xử lý

Cửa sổ ngữ cảnh càng lớn, mô hình càng phải xử lý nhiều token hơn mỗi lần truy vấn, dẫn đến tăng tiêu thụ tài nguyên GPU, bộ nhớ RAM và thời gian phản hồi. Với context hàng trăm nghìn token, chi phí huấn luyện và vận hành mô hình có thể tăng gấp nhiều lần so với context nhỏ.

Vấn đề thất lạc thông tin trong Context dài

Context quá dài khiến mô hình phải phân bổ trọng số attention cho hàng trăm nghìn token, dẫn đến hiện tượng mất tập trung hoặc mờ nhạt thông tin quan trọng. Dù mô hình có thể đọc nhiều nội dung, nhưng việc hiểu sâu từng phần lại trở nên khó khăn. Đây là lý do các nhà nghiên cứu đang phát triển cơ chế attention chọn lọc hoặc retrieval-based attention để mô hình chỉ tập trung vào những phần dữ liệu thực sự liên quan.

Chi phí sử dụng cho người dùng cuối

Đối với người dùng hoặc doanh nghiệp, mỗi token đều được tính phí. Khi context window mở rộng lên hàng trăm nghìn token, chi phí một lượt truy vấn có thể tăng gấp nhiều lần. Do đó, việc cân đối giữa độ dài ngữ cảnh và chi phí sử dụng là điều bắt buộc, đặc biệt với các ứng dụng AI thương mại như Chatbot, hệ thống hỏi đáp tài liệu hay trợ lý nội bộ.

Xem thêm: Tối ưu context window cho hội thoại dài - Giải pháp cho LLM

Ứng dụng Context Window dài trong thực tế

Việc mở rộng Context Window không chỉ là bước tiến về mặt kỹ thuật mà còn mang ý nghĩa thực tiễn sâu sắc, khi giúp các mô hình ngôn ngữ lớn (LLM) xử lý khối lượng dữ liệu khổng lồ, hiểu nội dung liền mạch và duy trì mạch tư duy logic như con người. Dưới đây là những ứng dụng nổi bật của context dài trong đời sống và doanh nghiệp hiện nay.

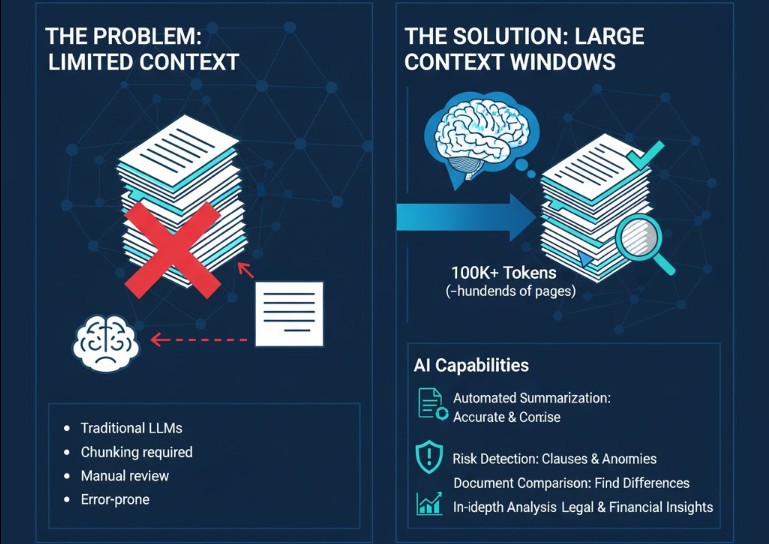

Phân tích và tóm tắt tài liệu, hợp đồng, báo cáo tài chính

Với Context Window hàng trăm nghìn token, LLM có thể xử lý trọn vẹn hàng trăm trang tài liệu trong một lần prompt, thay vì phải chia nhỏ từng phần như trước. Nhờ đó, AI có thể:

- Tự động tóm tắt nội dung chính xác, cô đọng.

- Phát hiện rủi ro hoặc điều khoản bất thường trong hợp đồng.

- So sánh nhiều tài liệu để tìm ra điểm khác biệt, phục vụ phân tích pháp lý hoặc kiểm toán.

Ứng dụng này đặc biệt hữu ích cho doanh nghiệp tài chính, luật, bảo hiểm, đầu tư, nơi việc đọc hiểu và tổng hợp thông tin chính xác là yếu tố sống còn.

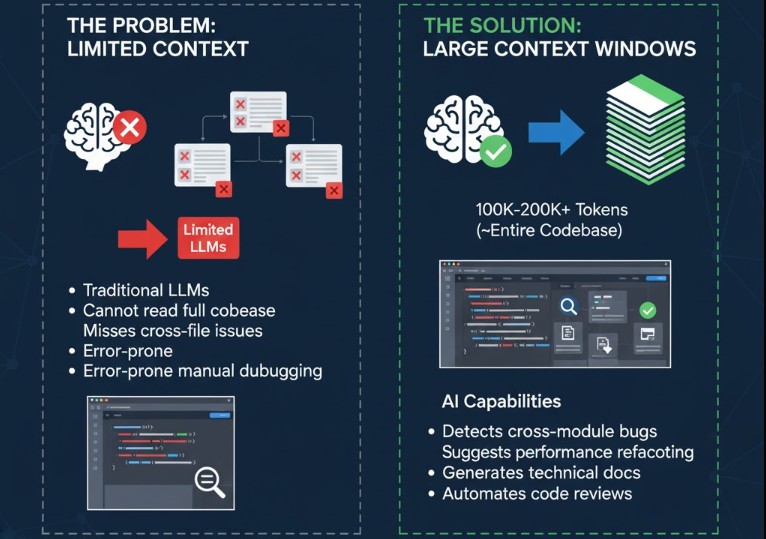

Lập trình và sửa lỗi trên Source Code lớn

Trước đây, các mô hình AI chỉ có thể xử lý một phần code nhỏ, khiến việc sửa lỗi hoặc phân tích hệ thống lớn trở nên giới hạn.

Nhưng với context 100K–200K token, mô hình có thể đọc toàn bộ lịch sử, nhận biết mối liên kết giữa các file, từ đó:

- Phát hiện bug hoặc xung đột logic xuyên module.

- Gợi ý tái cấu trúc code để tăng hiệu suất.

- Sinh tài liệu kỹ thuật tự động, thống nhất cách đặt tên biến, function và API.

Nhờ khả năng này, developer có thể cộng tác với AI như một code reviewer thực thụ, giảm đáng kể thời gian bảo trì hệ thống.

Xây dựng Chatbot/Agent chuyên biệt, duy trì lịch sử trò chuyện dài

Một trong những ứng dụng rõ rệt nhất của context dài là trong việc phát triển Chatbot hoặc AI Agent thông minh.

Các mô hình như BizChatAI hoặc OpenAI GPT-4 Turbo có thể ghi nhớ toàn bộ lịch sử hội thoại hàng chục ngàn dòng, giúp:

- Giữ mạch trò chuyện liền mạch, không lặp lại.

- Hiểu phong cách, ngữ điệu và mục tiêu của người dùng.

- Hỗ trợ tư vấn chuyên sâu theo ngữ cảnh liên tục từ chăm sóc khách hàng, đào tạo nội bộ, đến phân tích dữ liệu doanh nghiệp.

Kết luận

Context Window là nền tảng cốt lõi định hình khả năng hiểu, nhớ và phản hồi của AI. Việc nắm rõ cơ chế, giới hạn và cách tận dụng context dài giúp bạn tối ưu chi phí, cải thiện hiệu suất mô hình và mở rộng ứng dụng thực tế trong các lĩnh vực từ dữ liệu, lập trình đến chăm sóc khách hàng.

Về trang chủ Bizfly

Về trang chủ Bizfly

Đăng nhập

Đăng nhập

Tài liệu kỹ thuật AI Chat

Tài liệu kỹ thuật AI Chat

Loading ...

Loading ...